en ambos casos.

Si la probabilidad de que un niño expuesto a una enfermedad contagiosa la contraiga es 0,40, ¿cuál es la probabilidad de que el décimo niño expuesto a la enfermedad sea el tercero en contraerla? En este caso, X es el número de niños expuestos la enfermedad y

En un proceso de manufactura se sabe que un promedio de1 en cada 10 productos es defectuoso, ¿cual es la probabilidad que el quinto (5) articulo examinado sea el tercero (3) en estar defectuoso?. La solucion es: X= articulos defectuosos P= 1/10 = 0,1 q= 1- 0,1 = 0,9 x= 5 ensayos K= 1 b*(5;1,0.1)=(5-11-1)(0.1)^1*(0.9)^5-1= b*(5;1,0.1)= 6.6% de probabilidad que el quinto elemento extraido sea el primero en estar defectuoso.

En teoría de probabilidad y estadística, la distribución de Poisson es una distribución de probabilidad discreta que expresa la probabilidad que un determinado número de eventos ocurran en un determinado periodo de tiempo, dada una frecuencia media conocida e independientemente del tiempo discurrido desde el último evento.

Fue descubierta por Siméon-Denis Poisson, que la dio a conocer en 1838 en su trabajo Recherches sur la probabilité des jugements en matières criminelles et matière civile (Investigación sobre la probabilidad de los juicios en materias criminales y civiles).

Propiedades

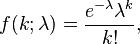

La función de masa de la distribución de Poisson es

donde

- k es el número de ocurrencias del evento o fenómeno (la función nos da la probabilidad de que el evento suceda precisamente k veces).

- λ es un parámetro positivo que representa el número de veces que se espera que ocurra el fenómeno durante un intervalo dado. Por ejemplo, si el suceso estudiado tiene lugar en promedio 4 veces por minuto y estamos interesados en la probabilidad de que ocurra k veces dentro de un intervalo de 10 minutos, usaremos un modelo de distribución de Poisson con λ = 10×4 = 40.

- e es la base de los logaritmos naturales (e = 2,71828 ...)

Tanto el valor esperado como la varianza de una variable aleatoria con distribución de Poisson son iguales a λ. Los momentos de orden superior son polinomios de Touchard en λ cuyos coeficientes tienen una interpretación combinatorio. De hecho, cuando el valor esperado de la distribución de Poisson es 1, entonces según la fórmula de Dobinski, el n-ésimo momento iguala al número de particiones de tamaño n.

La moda de una variable aleatoria de distribución de Poisson con un λ no entero es igual a  , el mayor de los enteros menores que λ (los símbolos

, el mayor de los enteros menores que λ (los símbolos  representan la función parte entera). Cuando λ es un entero positivo, las modas son λ y λ − 1.

representan la función parte entera). Cuando λ es un entero positivo, las modas son λ y λ − 1.

La función generadora de momentos de la distribución de Poisson con valor esperado λ es

Las variables aleatorias de Poisson tienen la propiedad de ser infinitamente divisibles.

La divergencia Kullback-Leibler desde una variable aleatoria de Poisson de parámetro λ0 a otra de parámetro λ es

Relación con otras distribuciones

Sumas de variables aleatorias de Poisson

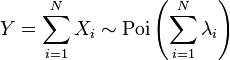

La suma de variables aleatorias de Poisson independientes es otra variable aleatoria de Poisson cuyo parámetro es la suma de los parámetros de las originales. Dicho de otra manera, si

son N variables aleatorias de Poisson independientes, entonces

.

.

Distribución binomial

La distribución de Poisson es el caso límite de la distribución binomial. De hecho, si los parámetros n y θ de una distribución binomial tienden a infinito de manera que  se mantenga constante, la distribución límite obtenida es de Poisson.

se mantenga constante, la distribución límite obtenida es de Poisson.

Aproximación normal

Como consecuencia del teorema central del límite, para valores grandes de λ, una variable aleatoria de Poisson X puede aproximarse por otra normal dado que el cociente

converge a una distribución normal de media nula y varianza 1.

Distribución exponencial

Supóngase que para cada valor t > 0, que representa el tiempo, el número de sucesos de cierto fenómeno aleatorio sigue una distribución de Poisson de parámetro λt. Entonces, los tiempos discurridos entre dos sucesos sucesivos sigue la distribución exponencial.

Ejemplos

Si el 2% de los libros encuadernados en cierto taller tiene encuadernación defectuosa, para obtener la probabilidad de que 5 de 400 libros encuadernados en este taller tengan encuadernaciones defectuosas usamos la distribución de Poisson. En este caso concreto, k es 5 y , λ, el valor esperado de libros defectuosos es el 2% de 400, es decir, 8. Por lo tanto, la probabilidad buscada es

Este problema también podría resolverse recurriendo a una distribución binomial de parámetros k = 5, n = 400 y θ=0,02.

Procesos de Poisson

La distribución de Poisson se aplica a varios fenómenos discretos de la naturaleza (esto es, aquellos fenómenos que ocurren 0, 1, 2, 3,... veces durante un periodo definido de tiempo o en un área determinada) cuando la probabilidad de ocurrencia del fenómeno es constante en el tiempo o el espacio. Ejemplos de estos eventos que pueden ser modelados por la distribución de Poisson incluyen:

- El número de autos que pasan a través de un cierto punto en una ruta (suficientemente distantes de los semáforos) durante un periodo definido de tiempo.

- El número de errores de ortografía que uno comete al escribir una única página.

- El número de llamadas telefónicas en una central telefónica por minuto.

- El número de servidores web accedidos por minuto.

- El número de animales muertos encontrados por unidad de longitud de ruta.

- El número de mutaciones de determinada cadena de ADN después de cierta cantidad de radiación.

- El número de núcleos atómicos inestables que decayeron en un determinado período en una porción de sustancia radiactiva. La radiactividad de la sustancia se debilitará con el tiempo, por lo tanto el tiempo total del intervalo usado en el modelo debe ser significativamente menor que la vida media de la sustancia.

- El número de estrellas en un determinado volumen de espacio.

- La distribución de receptores visuales en la retina del ojo humano.

- La inventiva de un inventor a lo largo de su carrera.

4.-Distribución geométrica

En teoría de probabilidad y estadística, la distribución geométrica es cualquiera de las dos distribuciones de probabilidad discretas siguientes:

- la distribución de probabilidad del número X del ensayo de Bernoulli necesaria para obtener un éxito, contenido en el conjunto { 1, 2, 3,...} o

- la distribución de probabilidad del número Y = X − 1 de fallos antes del primer éxito, contenido en el conjunto { 0, 1, 2, 3,... }.

Cual de éstas es la que uno llama "la" distribución geométrica, es una cuestión de convención y conveniencia.

Propiedades

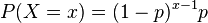

Si la probabilidad de éxito en cada ensayo es p, entonces la probabilidad de que x ensayos sean necesarios para obtener un éxito es

para x = 1, 2, 3,.... Equivalentemente, la probabilidad de que haya x fallos antes del primer éxito es

para x = 0,1, 2, 3,....

En ambos casos, la secuencia de probabilidades es una progresión geométrica.

El valor esperado de una variable aleatoria X distribuida geométricamente es

-

y dado que Y = X-1,

-

En ambos casos, la varianza es

-

Las funciones generatrices de probabilidad de X y la de Y son, respectivamente,

-

Como su análoga continua, la distribución exponencial, la distribución geométrica carece de memoria. Esto significa que si intentamos repetir el experimento hasta el primer éxito, entonces, dado que el primer éxito todavía no ha ocurrido, la distribución de probabilidad condicional del número de ensayos adicionales no depende de cuantos fallos se hayan observado. El dado o la moneda que uno lanza no tiene "memoria" de estos fallos. La distribución geométrica es de hecho la única distribución discreta sin memoria.

De todas estas distribuciones de probabilidad contenidas en {1, 2, 3,... } con un valor esperado dado μ, la distribución geométrica X con parámetro p = 1/μ es la de mayor entropía.

La distribución geométrica del número y de fallos antes del primer éxito es infinitamente divisible, esto es, para cualquier entero positivo n, existen variables aleatorias independientes Y 1,..., Yn distribuidas idénticamente la suma de las cuales tiene la misma distribución que tiene Y. Estas no serán geométricamente distribuidas a menos que n = 1.

Distribuciones relacionadas

La distribución geométrica es un caso especial de la distribución binomial negativa con parámetro k = 1. Más generalmente, si Y 1,...,Yk son variables independientes distribuidas geométricamente con parámetro p, entonces  sigue a una distribución binomial negativa con parámetros k y p.

sigue a una distribución binomial negativa con parámetros k y p.

Si Y1,...,Yr son variables independientes distribuidas geométricamente (con diferentes parámetros de éxito pm posibles ), entonces su mínimo W = minmYm es también geométricamente distribuido, con parámetro

5.- Distribución hipergeométrica

De Wikipedia, la enciclopedia libre

En teoría de la probabilidad la distribución hipergeométrica es una distribución discreta relacionada con muestreos aleatorios y sin reemplazo. Supóngase que se tiene una población de N elementos de los cuales, d pertenecen a la categoría A y N-d a la B. La distribución hipergeométrica mide la probabilidad de obtener x ( ) elementos de la categoría A en una muestra de n elementos de la población original.

) elementos de la categoría A en una muestra de n elementos de la población original.

Propiedades

La función de probabilidad de una variable aleatoria con distribución hipergeométrica puede deducirse a través de razonamientos combinatorios y es igual a

donde N es el tamaño de población, n es el tamaño de la muestra extraída

, d es el número de elementos en la población original que pertenecen a la

categoría deseada y x es el número de elementos en la muestra que pertenecen

a dicha categoría. La notación  hace referencia al coeficiente binomial,

hace referencia al coeficiente binomial,

es decir, el número de combinaciones posibles al seleccionar b elementos de un total a.

El valor esperado de una variable aleatoria X que sigue la distribución hipergeométrica es

![E[X]=frac{nd}{N}](http://upload.wikimedia.org/math/e/d/b/edb7931c237719680795389c71e2ca37.png)

y su varianza,

![Var[X]=bigg(frac{N-n}{N-1}bigg)bigg(frac{nd}{N}bigg)bigg( 1-frac{d}{N}bigg).](http://upload.wikimedia.org/math/9/b/2/9b21150dd51ee2e8e3c219b9d6c67cdd.png)

En la fórmula anterior, definiendo

y

se obtiene

![Var[X]=npqfrac{N-n}{N-1}.](http://upload.wikimedia.org/math/8/4/5/8450776365971ac3ed36f95d91b68b22.png)

La distribución hipergeométrica es aplicable a muestreos sin reemplazo y

la binomial a muestreos con reemplazo. En situaciones en las que el número

esperado de repeticiones en el muestreo es presumiblemente bajo, puede

aproximarse la primera por la segunda. Esto es así cuando N es grande y

el tamaño relativo de la muestra extraída, n/N, es pequeño.

6.-Distribución de Bernoulli

De Wikipedia, la enciclopedia libre

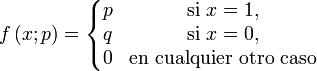

En teoría de probabilidad y estadística, la distribución de Bernoulli (o distribución dicotómica), nombrada así por el matemático y científico suizo Jakob Bernoulli, es una distribución de probabilidad discreta, que toma valor 1 para la probabilidad de éxito (p) y valor 0 para la probabilidad de fracaso (q = 1 − p).

Si X es una variable aleatoria que mide "número de éxitos", y se realiza un único experimento con dos posibles resultados (éxito o fracaso), se dice que la variable aleatoria X se distribuye como una Bernoulli de parámetro p.

X˜Be(p)

La fórmula será:

f(x) = px(1 − p)1 − x con x = {0,1}

Su función de probabilidad viene definida por:

Un experimento al cual se aplica la distribución de Bernoulli se conoce

como Ensayo de Bernoulli o simplemente ensayo, y la serie de esos

experimentos como ensayos repetidos.

Propiedades características

Esperanza matemática:

![Eleft[Xright] = p](http://upload.wikimedia.org/math/9/8/8/98871c2cbe354046c944e23318038577.png)

Varianza:

![varleft[Xright] = p left(1 - pright) = p q](http://upload.wikimedia.org/math/b/c/8/bc80ba4ce849763cc532daedbc7d2f46.png)

Función generatriz de momentos:

Función característica:

Moda:

- 0 si q > p (hay más fracasos que éxitos)

- 1 si q < p (hay más éxitos que fracasos)

- 0 y 1 si q = p (los dos valores, pues hay igual número de fracasos que de éxitos)

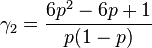

Asimetría (Sesgo):

Curtosis:

La Curtosis tiende a infinito para valores de p cercanos a 0 ó a 1, pero

para  la distribución de Bernoulli tiene un valor de curtosis menor que el de cualquier otra distribución, igual a -2.

la distribución de Bernoulli tiene un valor de curtosis menor que el de cualquier otra distribución, igual a -2.

Distribuciones Relacionadas

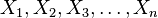

- Si

son n variables aleatorias identicamente distribuidas con la distribución de Bernoulli con la misma probabilidad de éxito p en todas, entonces la variable aleatoria

son n variables aleatorias identicamente distribuidas con la distribución de Bernoulli con la misma probabilidad de éxito p en todas, entonces la variable aleatoria  presenta una Distribución Binomial de probabilidad.

presenta una Distribución Binomial de probabilidad.

X˜Bi(n,p)

Ejemplo

"Lanzar una moneda, probabilidad de conseguir que salga cruz".

Se trata de un solo experimento, con dos resultados posibles: el éxito (p) se considerará sacar cruz. Valdrá 0,5. El fracaso (q) que saliera cara, que vale (1 - p) = 1 - 0,5 = 0,5.

La variable aleatoria X medirá "número de cruces que salen en un lanzamiento", y sólo existirán dos resultados posibles: 0 (ninguna cruz, es decir, salir cara) y 1 (una cruz).

Por tanto, la v.a. X se distribuirá como una Bernoulli, ya que cumple todos los requisitos.

X˜Be(0,5)

P(X = 0) = f(0) = 0,500,51 = 0,5

P(X = 1) = f(1) = 0,510,50 = 0,5

Ejemplo:

"Lanzar un dado y salir un 6".

Cuando lanzamos un dado tenemos 6 posibles resultados:

Ω = {1,2,3,4,5,6}

Estamos realizando un único experimento (lanzar el dado una sola vez).

Se considera éxito sacar un 6, por tanto, la probabilidad según el teorema de Laplace (casos favorables dividido entre casos posibles) será 1/6.

p = 1 / 6

Se considera fracaso no sacar un 6, por tanto, se considera fracaso sacar cualquier otro resultado.

q = 1 − p = 1 − 1 / 6 = 5 / 6

La variable aleatoria X medirá "número de veces que sale un 6", y solo existen dos valores posibles, 0 (que no salga 6) y 1 (que salga un 6).

Por tanto, la variable aleatoria X se distribuye como una Bernoulli de parámetro p = 1/6

X˜Be(1 / 6)

La probabilidad de que obtengamos un 6 viene definida como la probabilidad de que X sea igual a 1.

P(X = 1) = f(1) = (1 / 6)1 * (5 / 6)0 = 1 / 6 = 0.1667

La probabilidad de que NO obtengamos un 6 viene definida como la probabilidad de que X sea igual a 0.

P(X = 0) = f(0) = (1 / 6)0 * (5 / 6)1 = 5 / 6 = 0.8333

7.-Distribución uniforme discreta

Propiedades

Distribución uniforme (caso discreto).

Si la distribución asume los valores reales  , su función de probabilidad es

, su función de probabilidad es

y su función de distribución la función escalonada

![F(x)=frac{1}{n} sum_i 1_{(-infty,x]}(x_i),!.](http://upload.wikimedia.org/math/d/1/9/d19f430201b6527b7e1205811c266aea.png)

Su media estadística es

y su varianza

Ejemplos

- Para un dado perfecto, todos los resultados tienen la misma probabilidad 1/6. Luego, la probabilidad de que al lanzarlo caiga 4 es 1/6.

- Para una moneda perfecta, todos los resultados tienen la misma probabilidad 1/2. Luego, la probabilidad de que al lanzarla caiga cara es 1/2.